Pangu Ultra MoE 是一个全流程在昇腾 NPU 上训练的准万亿 MoE 模型,此前发布了英文技术报告[1]。最近华为盘古团队发布了 Pangu Ultra MoE 模型架构与训练方法的中文技术报告,进一步披露了这个模型的细节。

训练超大规模和极高稀疏性的 MoE 模型极具挑战,训练过程中的稳定性往往难以保障。针对这一难题,盘古团队在模型架构和训练方法上进行了创新性设计,成功地在昇腾 NPU 上实现了准万亿 MoE 模型的全流程训练。

盘古团队提出 Depth-Scaled Sandwich-Norm(DSSN)稳定架构和 TinyInit 小初始化的方法,在昇腾 NPU 上实现了 10+ T tokens 数据的长期稳定训练。此外,他们还提出了 EP group loss 负载优化方法,这一设计不仅保证了各个专家之间能保持较好的负载均衡,也提升了专家的领域特化能力。同时,Pangu Ultra MoE 使用了业界先进的 MLA 和 MTP 架构,在训练时使用了 Dropless 训练策略。

-

技术报告标题:Pangu Ultra MoE 模型架构与训练方法

-

技术报告地址:https://raw.gitcode.com/ascend-tribe/pangu-ultra-moe/raw/main/Pangu_Ultra_MoE_CN_Report.pdf

破解准万亿 MoE 模型性能瓶颈

打造芯片协同的先进架构

近期,盘古团队在 MoE 模型训练领域再进一步,重磅推出参数规模高达 718B 的准万亿全新模型 ——Pangu Ultra MoE。该模型旨在实现超大规模 MoE 架构在模型效果与效率之间的最佳平衡。

为了达到这个目标,研究团队在设计 Pangu Ultra MoE 架构的时候,充分考虑昇腾硬件特性,在昇腾 NPU 平台上,融合计算、通信和内存等多维度指标,构建了大规模系统模拟器,并系统性地探索约一万个不同的 MoE 结构组合,最终搜索出一套在训练与推理吞吐上均达最优的架构方案。

Pangu Ultra MoE 是一个超大规模、高稀疏比的架构,同时也包含 MLA 和 MTP 等先进架构和特有的 DSSN 稳定性架构和 EP group loss 负载优化。下面是 Pangu Ultra MoE 的主要的架构和训练特性:

-

超大规模和超高稀疏比:采用 256 个路由专家,每个 token 激活 8 个专家,模型总参数量 718B,激活量 39B。

-

MLA 注意力机制:引入 MLA(Multi-head Latent Attention),有效压缩 KV Cache 空间,缓解推理阶段的内存带宽瓶颈,优于传统 GQA 方案。

-

MTP 多头扩展:采用单头 MTP 进行训练,后续复用 MTP 参数扩展至多头结构,实现多 Token 投机推理,加速整体推理过程。

-

Dropless 训练:采用 Dropless 训练可以避免 Drop&Pad 训推不一致问题,并且提升训练的数据效率。

-

RL 训练:采用迭代难例挖掘与多能力项均衡的奖励函数,并参考 GRPO 算法,提升了模型的训练效率与最终推理性能。

以下是 Pangu Ultra MoE 昇腾亲和设计考虑:

-

隐藏维度贴合硬件:设置 7680 维隐藏层,精准匹配昇腾芯片的 16×16 MatMul 单元,充分发挥 Cube 核心的计算潜力。

-

层数亲和流水线并行:设置 61 层 Transformer 结构,并预留额外 MTP 层空间,保障计算负载均衡的 PP/VPP 流水线调度,减少 pipeline 气泡,提升整体并行效率。

-

专家规模符合幂次规律:路由专家数量设为2⁸=256,在 TP×EP 并行下提升 All-to-All 通信效率,有效加速分布式训练。

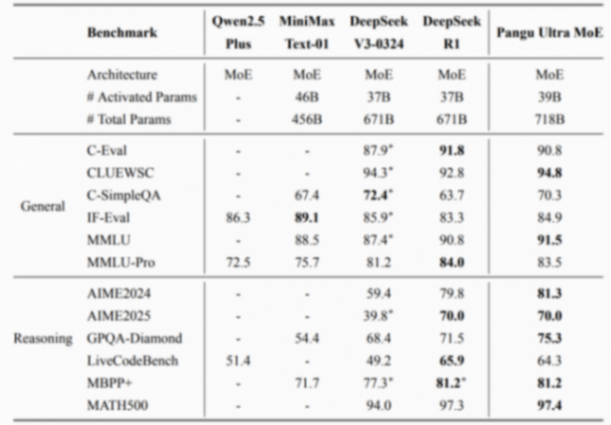

Pangu Ultra MoE 的预训练阶段在 6k 到 10k 张 NPU 上进行,全流程采用 dropless 训练模式。预训练阶段进行了长序列扩展,最终模型具备 128k 长序列能力。在后训练阶段,Pangu Ultra MoE 移除了负载均衡辅助损失,保留专家间已有的特化能力,从而进一步提升模型对目标数据的学习效率。如表1所示,最终模型在多个权威开源评测集上展现出一流的效果。